Si buscas

hosting web,

dominios web,

correos empresariales o

crear páginas web gratis,

ingresa a

PaginaMX

Por otro lado, si buscas crear códigos qr online ingresa al Creador de Códigos QR más potente que existe

http://etl-tools.info/en/datastage-tutorial-L004_extracting-and-loading-data-sequential-files.htm

Etl Tools info

La información en esta portada trata sobre diferentes herramientas y conceptos Business Intelligence - sobre todo en soluciones en el área de Almacenes de Datos y el proceso ETL (con muchos ejemplos en IBM Websphere Datastage).

El proceso ETL organiza el flujo de los datos entre diferentes sistemas en una organización y esta fase de importar y cargar datos se suele realizar con una herramienta ETL (como por ejemplo Informatica Powercenter, Datastage). También es posible y ocurre a menudo programar el proceso ETL en el lenguaje dedicado a la base de datos (PL/SQL por ejemplo).

El almacén de datos puede ser implementado en una arquitectura de base de datos (como Oracle, SQL Server) o en un producto dedicado (Teradata por ejemplo).

Inteligencia empresarial o Inteligencia de negocios (Business Intelligence)

Inteligencia empresarial (Business Intelligence), también llamado “Gestión de los Datos” (Data Management), es un agregado de aplicaciones y herramientas enfocadas al procesamiento de los datos en una empresa para poder ayudar tomar decisiones y hacer varios análisis. Inteligencia empresarial realiza gestión de datos, consultas a los datos, generación de los informes/reportes y más específicamente todo el procesamiento para traducir la lógica de negocios a la lógica de sistemas empresariales.

Las áreas más importantes de Business Intelligence son:

- DW - Almacenes de datos, Bodegas de Datos (Data warehouses)

- ETL - Transformar, Extraer y Cargar datos

- DM - Minería de datos (Data mining)

- Aplicaciones OLAP - cubos OLAP, procesamiento analítico línea, Online Analytical Processing and multidimensional analysis

- MIS - Sistemas de Información para la Administración (Management Information Systems)

- Consultas e informes - Information visualization, and Dashboarding

- Calidad de Datos y limpieza de Datos

- Sistemas de previsión empresarial

- DSS - Apoyo en la toma de decisiones (Decision Support Systems)

- CRM - Customer Relationship Management

Almacén de datos - concepto

Almacén de datos (Bodega de Datos, Data warehouse) es una integrada colección de datos que contiene datos procedentes de sistemas del planeamiento del recurso de la empresa (SAP, CRM, ERP) y de otros sistemas relacionados al negocio. Los almacenes de datos contienen a menudo datos y parámetros introducidos manualmente para mantener configuración solicitada.

Los almacenes de datos contienen información que se subdivide a veces en unidades lógicas más pequeñas, llamadas los centros comerciales (data marts).

Almacén de datos contiene datos usados en operaciones diarias para la ayuda en la toma de decisiones, para el análisis y para controlar.

La base de datos esta actualizada periódicamente sin interrumpir funcionamiento de los sistemas relacionados al negocio (múltiples fuentes).

El almacén de datos puede ser implementado en una arquitectura de base de datos (como Oracle, SQL Server) o en un producto dedicado (Teradata por ejemplo).

Arquitectura de un sistema de almacén de datos

Un Almacén de Datos (Data Warehouse) es una colección de datos que está formada por Variables (hechos, facts) y Dimensiones (dimensions). Dimensiones son los elementos para ubicar datos que participan en el análisis y Variables los valores que se desean analizar.

La mayor diferencia entre la arquitectura de un almacén de datos y una base de datos OLTP estándar, conteniendo datos de los sistemas del planeamiento del recurso de la empresa (como SAP, CRM) es que en una estructura de bodega de datos las tablas están denormalizadas entre variables y dimensiones.

En un típico sistema de bases de datos OLTP (On-line Transaction Processing) lo más importante para el funcionamiento deseado es que el diseño de base de datos sea eficiente. Esto determina si el sistema es útil para los usuarios y si funciona de modo rápido y eficaz.

Este tipo de base de datos tiene que encargarse de insertar miles de filas de datos cada hora. Por eso se optimiza la base de datos para guardar datos lo menos posible y ejecutar rápidamente las instrucciones sql: INSERT, UPDATE y DELETE.

Almacén de Datos, al contrario de OLTP, es un sistema que debe dar una respuesta a casi cada pregunta con respeto al funcionamiento de la empresa. Una Bodega de datos es una base de datos que almacena información, la cual se construye a partir de datos básicos extraidos de otras bases de datos (operacionales). El motivo para producir información de una bodega de datos es ayudar a la toma de decisiones con la capacidad de realizar en tiempo real análisis multidimensionales Esta información tiene que ser accesible rápidamente, pero no es tan importante que sea lo mas actual posible y al nivel de detalle muy bajo. Normalmente un almacén de datos se carga diariamente durante la noche cuando los sistemas fuente no están sobrecargados. El objeto mayor de la arquitectura de un almacén de datos es guardar datos históricos y agregados. Las instrucciones SQL ejecutadas con mayor frecuencia son SELECT .

Hay tres arquitecturas del diseño de sistemas de almacenes de datos:

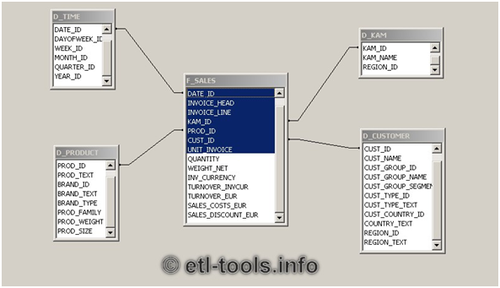

Esquema estrella (Star schema)

Esquema de la estrella es la arquitectura de almacén de datos más simple. En este diseño del almacén de datos la tabla de Variables (Hechos) esta rodeada por Dimensiones y juntos forman una estructura que permite implementar mecanismos básicos para poder utilizarla con una herramienta de consultas OLAP.

Esquema estrella del Almacén de Datos implementa un diseño lógico relacional de base da datos que resulta en que las tablas de hechos representan la Tercera Forma Normal (3FN) y las dimensiones representan la Segunda Forma Normal (2FN).

El motivo por dejar de mantener las tablas en el modelo relacional y permitir el almacenamiento de información redundante, es optimizar el tiempo de respuesta de base datos y dar información a un usuario en menos tiempo posible. En este modelo, para obtener información solicitada no hay que construir una sentencia SQL muy compleja que lease muchas tablas de una vez. Una herramienta de consultas sólo tiene que acceder una tabla.

La clave primaria de una tabla de hechos está formada por todas las columnas que corresponden a las dimensiones (como por ejemplo ID_CLIENTE, ID_ARTICULO, ID_TIEMPO). Las columnas que contienen los datos numéricos no forman parte de la clave primaria, porque están agregadas en los informes (ejemplos de este tipo de columnas: CANTIDAD, PRECIO, VENTA_TOTAL, IVA).

Se puede encontrar casi cada información de una tabla de hechos en una tabla de dimensiones. Lo característico de la arquitectura de estrella es que sólo existe una tabla de dimensiones para cada dimensión y esta tabla representa la segunda forma normal.

Un ejemplo del esquema de estrella

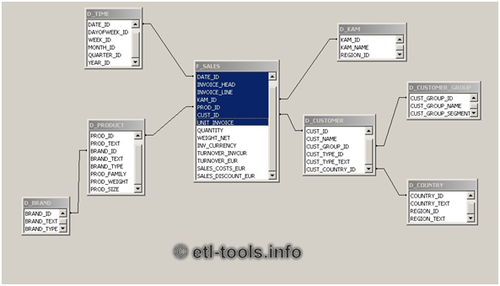

Esquema en copos de nieve

Esquema en copo de nieve (bola de nieve) es una variedad más compleja del esquema estrella. El afinamiento está orientado a facilitar mantenimiento de dimensiones.

Lo que distingue a la arquitectura en copo de nieve de la esquema estrella, es que las tablas de dimensiones en este modelo representan relaciones normalizadas (3NF) y forman parte de un modelo relacional de base de datos.

Con varios usos del esquema en bola de nieve, el más común es cuando las tablas de dimensiones están muy grandes o complejos y es muy difícil representar los datos en esquema estrella.

Por ejemplo, si una tabla dimensional de los clientes (CUSTOMERS) contiene un million de filas, seria una idea buena crear una tabla con grupos de clientes (CUSTOMER_GROUPS) y mover los datos comunes para cada grupo de clientes a esta tabla. El tamaño de estas dos tablas será mucho menor que de una tabla no normalizada con todos los datos de clientes.

El problema es que para extraer datos de las tablas en esquema de copo de nieve, a veces hay que vincular muchas tablas en las sentencias SQL que puede llegar a ser muy complejo y difícil para mantener.

Un ejemplo del esquema en copos de nieve

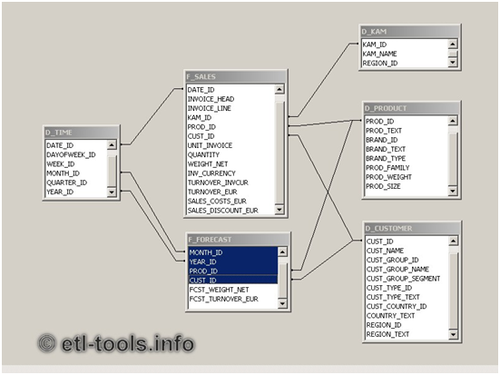

Esquema de constelación de hechos (fact constellation schema)

Para cada esquema estrella o esquema del copo de nieve en almacén de datos es posible construir un esquema de constelación de hechos.

Este esquema es más complejo que las otras arquitecturas debido al facto de que contiene multiples tablas de hechos. Con este solución las tablas de dimensiones pueden estar compartidas entre mas que una tabla de los factos.

El esquema de constelación de hechos tiene mucha flexibilidad y este facto es su grande virtud. Sin embargo, el problema es que cuando el número de las tablas vinculadas aumenta, la arquitectura puede llegar a ser muy compleja y difícil para mantener.

En una esquema de constelación de factos las distintas tablas de los hechos están asignadas a las dimensiones relevantes para cada de los hechos. Esto puede ser util cuando los hechos estan asignadas a un nivel de un dimensión y los otros hechos a otro nivel de detalle de un dimensión.

El modelo este puede ser una solución adecuada cuando por ejemplo hay una tabla de hechos de venta (con un nivel de detalle hasta un día y el numero de factura) y hay otra tabla de factos con los Pronósticos (con los campos clave: mes, código articulo, código cliente).

Un ejemplo del esquema de constelación de hechos

Proceso ETL

ETL - este termino viene de ingles de las siglas Extract-Transform-Load que significan Extraer, Transformar y Cargar y se refiere a los datos en una empresa. ETL es el proceso que organiza el flujo de los datos entre diferentes sistemas en una organización y aporta los métodos y herramientas necesarias para mover datos desde múltiples fuentes a un almacén de datos, reformatearlos, limpiarlos y cargarlos en otra base de datos, data mart ó bodega de datos. ETL forma parte de la Inteligencia Empresarial (Business Intelligence), también llamado “Gestión de los Datos” (Data Management).

La idea es que una aplicación ETL lea los datos primarios de unas bases de datos de sistemas principales, realice transformación, validación, el proceso cualitativo, filtración y al final escriba datos en el almacén y en este momento los datos son disponibles para analizar por los usuarios.

Los más populares herramientas y aplicaciones ETL del mercado

- IBM Websphere DataStage (anteriormente Ascential DataStage y Ardent DataStage)

- Pentaho Data Integration (Kettle ETL) - Una herramienta Open Source Business Intelligence

- SAS ETL Studio

- Oracle Warehouse Builder

- Informatica PowerCenter

- Cognos Decisionstream

- Ab Initio

- BusinessObjects Data Integrator (BODI)

- Microsoft SQL Server Integration Services (SSIS)

Fundamentos de DataStage

DataStage es una herramienta ETL que permite crear y mantener fácil y rápidamente almacenes de datos procedentes de sistemas de Aplicaciones Empresariales incluyendo SAP, Siebel, Oracle y PeopleSoft CRM y de otros sistemas relacionados al negocio.

Datastage soporta la extracción, integración y transformación de altos volúmenes de datos desde estructuras simples hasta muy complejas. Entre funciones de DataStage, la más destacada es el diseño de tareas que extraen, integran, agregan, cargan y transforman los datos para el Data Warehouse o Data Mart. Las tareas son compiladas para crear ejecutables que son calendarizados por el Director y ejecutadas por el Servidor.

Historia Datastage

Antes el producto se llamaba Ardent DataStage, luego adquirido por Ascential y en 2005 lo compró IBM. Desde entonces su nombre oficial es IBM WebSphere Datastage.

Versiones Datastage

DataStage es un software cliente/servidor. Entre otras plataformas soportadas hay Windows y Unix (IBM AIX).

Ediciones Datastage:

- Server Edition: server jobs (DS 7.5.1 server edition usado para el tutorial)

- Enterprise Edition - las tareas paralelas y server (parallel and server jobs)

- MVS Edition - soporta los jobs mainframe que son programadas en la plataforma Windows o Unix/Linux, compiladas y transferidas al mainframe.

- DataStage for PeopleSoft: server edition con PeopleSoft EPM.

- DataStage TX - transacciones complejas.

- DataStage SOA - integración con los servicios SOA.

Componentes DataStage

Hay cuatro componentes principales de la herramienta Datastage:

- Administrator - Interfaz de usuario usada para configurar proyectos de Datastage y usuarios. Gestiona administración de proyectos de DataStage en ambientes de desarrollo y producción.

- Designer - usada para crear, diseñar y compilar tareas Datastage (también permite testear y ejecutar). Mayormente usado por los desarrolladores.

- Director - para validar, calendarizar, testear, ejecutar y monitorizar jobs Datastage. Usado por los operadores y los testers.

- Manager - interfaz de usuario usada para visualizar y editar el contenido del repositorio.

Curso DataStage

Lecciones del curso Datastage:

· Lección 1. Componentes Datastage - descripción y pantallas (screenshots) de las cuatro componentes principales de la herramienta Datastage

· Lección 2. Diseño de tareas - Datastage palette - una lista grafica de todos los elementos usados en el diseño de tareas Datastage

· Lección 3. Extraer y cargar datos - los stages ODBC y ORACLE - descripción y ejemplos de uso de los stages ODBC y ORACLE (ORAOCI9) usados para extraer y para cargar datos. La lección cubre los vínculos ODBC de entrada y salida, los métodos de actualización de las tablas Oracle y las mejores prácticas. (Curso en inglés)

· Lección 4. Extracción y carga de datos - ficheros de texto - descripción y ejemplos de uso de los stages de ficheros de texto (sequential files, ficheros secuenciales, archivos CSV) en Datastage. (Curso en inglés)

· Lección 5. Transformar y filtrar datos - uso de los transformers para hacer conversiones de datos, los mappings, validación y manipulación de los datos. Ejemplos del diseño de tipos de tareas más usados.(Curso en inglés)

· Lección 6. Hacer lookups en datastage - los ficheros hash y comunicación con las bases de datos para referenciar datos.(Curso en inglés)

· Lección 7. Incorporar proceso ETL en Datastage - guía paso a paso de como implementar el proceso ETL en DataStage. Contiene las mejores prácticas de diseño y arquitectura del proceso y también un recomendado orden de ejecución de las tareas que alimentan diariamente un Almacén de Datos con los datos.(Curso en inglés)

· Lección 8. Implemenctación de SCD en Datastage - esta lección provee información sobre varios modos de implementación de los Dimensiones que Cambian Lentamente (SCD - Slowly Changing Dimensions) del en Datastage. Contiene ejemplos de Datastage jobs que implementan SCD1 (SCD Tipo 1), SCD2, SCD3 y SCD4.(Curso en inglés)

· Lección 9. Soluciones Datastage en la vida real - un número de ejemplos de las tareas DataStage que solucionan problemas de la vida real de los procesos ETL responsables por la carga de almacenes de datos comerciales.

Componentes DataStage

Hay cuatro componentes principales de la herramienta Datastage:

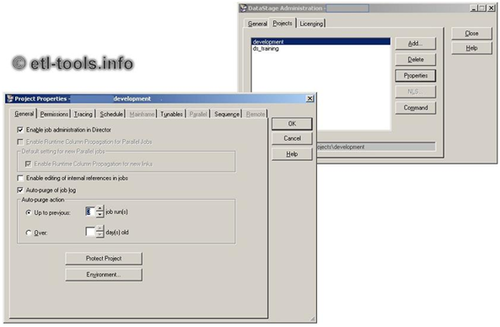

- Administrator - Interfaz de usuario usada para configurar proyectos de Datastage y usuarios. Gestiona administración de proyectos de DataStage en ambientes de desarrollo y producción.

- Designer - usada para crear, diseñar y compilar tareas Datastage (pero también permite testear y ejecutar). Mayormente usado por los desarrolladores.

- Director - para validar, calendarizar, testear, ejecutar y monitorizar jobs Datastage. Usado por los operadores y los testers.

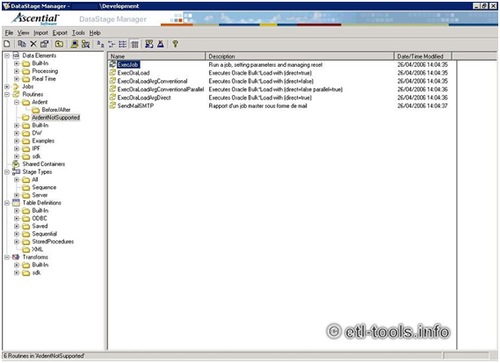

- Manager - interfaz de usuario usada para visualizar y editar el contenido del repositorio.

Pantalla de Datastage manager

Pantalla de Datastage Administrator

Agregar un comentario

722251

Pedro Ledezma

06 Oct 2017 - 09:37 am

Buenos dias, por favor me pueden indicar donde hago el curso de etl (Datastage) aqui argentina - Buenos Aires

Gracias

Paula Pallo

14 Sep 2015 - 02:59 pm

Hola, me contacto para saber donde se pueden hacer cursos de datastage en argentina. Gracias